Turinys:

ToggleTrumpai

- Mažas, atvirojo kodo AI modelis DIA-1,6B teigia, kad emocinės kalbos sintezėje įveikia pramonės milžinus, tokius kaip vienuolika ar sezamas.

- Sukurti įtikinamą emocinę AI kalbą išlieka sudėtinga dėl žmogaus emocijų sudėtingumo ir techninių apribojimų.

- Nors ji gerai atitinka konkurenciją, „Uncanny Valley“ problema išlieka, nes AI balsai skamba žmogiškai, tačiau nepavyksta perteikti niuansuotų emocijų.

„Nari Labs“ išleido „Dia-1.6b“-atvirojo kodo teksto į kalbą modelį, kuris teigia, kad pralenkia įsitvirtinusius žaidėjus, tokius kaip „ElevenTlabs“ ir „Sesame“, kurdamas emociškai išraiškingą kalbą. Modelis yra labai mažas – su vos 1,6 milijardo parametrų -, tačiau vis tiek gali sukurti realų dialogą su juoku, kosuliu ir emociniais posūkiais.

Tai netgi gali rėkti siaubingai.

Mes ką tik išsprendėme tekstą į kalbą AI.

Šis modelis gali modeliuoti tobulas emocijas, rėkdamas ir parodyti tikrą aliarmą.

– aiškiai įveikia 11 laboratorijų ir sezamą

– Tai tik 1,6B parametrai

– srautai realu 1 GPU

– Pagaminta 1,5 asmenų komanda Korėjoje !!Tai „Nari Labs“ vadina „Dia“. pic.twitter.com/RPEZ5LOE9Z

– Deedy (@Deedydas) 2025 m. Balandžio 22 d

Nors tai gali neatrodyti kaip didžiulis techninis žygdarbis, net „Openai“ pokalbiai yra tokie: „Aš negaliu rėkti, bet tikrai galiu kalbėti“, – atsakė jo pokalbių juosta, kai paklausė.

Dabar kai kurie PG modeliai gali rėkti, jei paprašysite jų. Bet tai nėra kažkas, kas nutinka natūraliai ar organiškai, o tai, matyt, yra DIA-1,6B super galia. Tai supranta, kad tam tikrose situacijose riksmas yra tinkamas.

„Nari“ modelis realiu laiku veikia viename GPU su 10 GB VRAM, apdorojant apie 40 žetonų per sekundę „NVIDIA A4000“. Skirtingai nuo didesnių uždaro kodo alternatyvų, „Dia-1,6b“ yra laisvai prieinamas pagal „Apache 2.0“ licenciją, naudojant „Hugning Face“ ir „GitHub“ saugyklas.

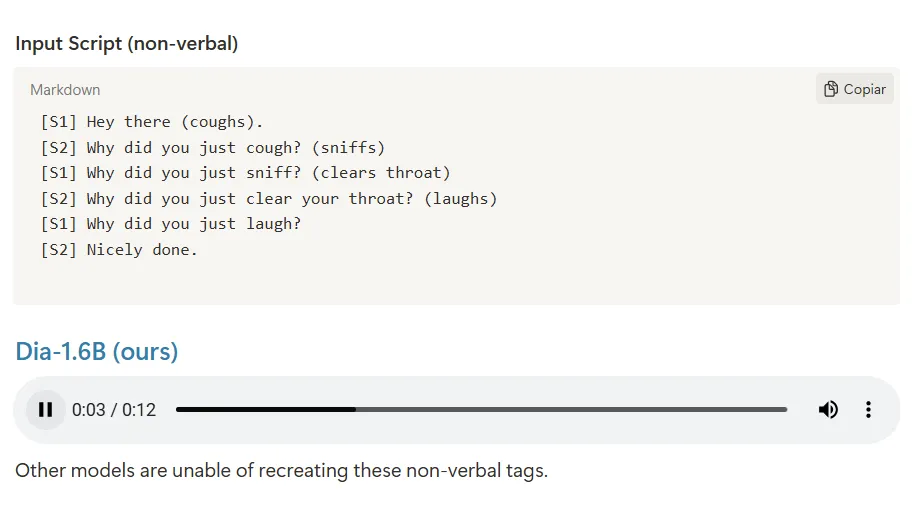

„Vienas juokingas tikslas: sukurkite TTS modelį, kuris konkuruoja su„ NotebooksLM Podcast “,„ EneveenLabs Studio “ir„ Sesame CSM “. Kažkaip mes jį atsitraukėme“,-paskelbdami modelį, „Nari Labs“ įkūrėjas Toby Kim paskelbė X. Palyginimai su šoniniu būdu rodo, kad DIA tvarkymas standartinis dialogas ir neverbalinės išraiškos yra geriau nei konkurentai, kurie dažnai išlygina pristatymą arba visiškai praleidžia neverbalines etiketes.

Lenktynės, kad padarytų emocinę AI

PG platformos vis labiau orientuojasi į tai, kad jų teksto į kalbą modeliai rodo emocijas, spręsdamos trūkstamą žmogaus ir mašinos sąveikos elementą. Tačiau jie nėra tobuli ir dauguma modelių – atidaryti ar uždaryti – tenka sukurti nepaprastą slėnio efektą, kuris sumažina vartotojo patirtį.

Mes išbandėme ir palyginome keletą skirtingų platformų, kuriose pagrindinis dėmesys skiriamas šiai specifinei emocinės kalbos temai, ir dauguma jų yra gana geros, jei vartotojai įsitraukia į tinkamą mąstyseną ir žino jų apribojimus. Tačiau ši technologija dar toli gražu nėra įtikinama.

Norėdami išspręsti šią problemą, tyrėjai naudojasi įvairiais metodais. Kai kurie traukinių modeliai duomenų rinkiniuose su emocinėmis etiketėmis, leidžiančiomis AI išmokti akustinius modelius, susijusius su skirtingomis emocinėmis būsenomis. Kiti naudoja gilius neuroninius tinklus ir didelius kalbų modelius, kad analizuotų kontekstinius užuominas, kad būtų galima sukurti tinkamus emocinius tonus.

Vienuolika, vienas iš rinkos lyderių, bando tiesiogiai aiškinti emocinį kontekstą iš teksto įvesties, žiūrint į kalbinius užuominas, sakinių struktūrą ir skyrybos ženklus, kad būtų galima nustatyti tinkamą emocinį toną. Jo pavyzdinis modelis, vienuolika daugiakalbių V2, yra žinomas dėl turtingos emocinės išraiškos 29 kalbomis.

Tuo tarpu „Openai“ neseniai paleido „GPT-4O-Mini-TTS“ su pritaikoma emocine išraiška. Demonstracijų metu įmonė pabrėžė galimybę nurodyti tokias emocijas kaip „atsiprašymas“ dėl klientų aptarnavimo scenarijų, kainodama apie 1,5 cento per minutę kainą, kad ji būtų prieinama kūrėjams. Jos pažengusio balso režimas gerai mėgdžioja žmogaus emocijas, tačiau yra toks perdėtas ir entuziastingas, kad negalėjo konkuruoti mūsų testų su kitomis alternatyvomis, tokiomis kaip Hume.

Kai DIA-1,6B gali nutraukti naują pagrindą, yra tai, kaip ji tvarko neverbalinius ryšius. Modelis gali sintetinti juoką, kosulį ir gerklės valymą, kai sukelia konkretūs teksto užuominos, tokios kaip „(juokiasi)“ arba „(kosulys)“ – pridedant realizmo sluoksnį, dažnai trūksta standartinių TTS rezultatų.

Be „Dia-1.6b“, kiti pastebimi atvirojo kodo projektai apima emovoice-kelių balsų TTS variklį, palaikantį emocijas kaip kontroliuojamą stiliaus veiksnį-ir Orfėjas, žinomas dėl ypač mažos latentinės ir gyvos emocinės išraiškos.

Sunku būti žmogumi

Bet kodėl emocinė kalba tokia sunki? Galų gale, AI modeliai seniai nustojo skambėti robotu.

Na, atrodo, kad natūralumas ir emocionalumas yra du skirtingi žvėrys. Modelis gali skambėti žmogiškai ir turėti skystą, įtikinamą toną, tačiau visiškai nepavyksta perteikti emocijų, viršijančių paprastą pasakojimą.

„Mano nuomone, emocinė kalbos sintezė yra sunki, nes duomenims, kuriais remiasi, trūksta emocinio detalumo. Dauguma mokymo duomenų rinkinių fiksuoja švarią ir suprantamą kalbą, bet ne giliai išraiškingą“, – pasakojo Kavehas Vahdatas, „AI Video Generation Company“ bendrovės „RiseanGle“ generalinis direktorius. Iššifruoti. „Emocija nėra tik tonas ar tūris; tai yra kontekstas, tempas, įtampa ir dvejonė. Šios savybės dažnai yra numanomos ir retai paženklintos taip, kad mašinos galėtų pasimokyti.”

„Net kai naudojamos emocijų etiketės, jos linkusios suplanuoti tikro žmogaus įtakos sudėtingumą į plačias kategorijas, tokias kaip„ laimingas “ar„ piktas “, tai toli gražu nėra tai, kaip emocijos iš tikrųjų veikia kalboje“, – teigė Vahdatas.

Mes išbandėme DIA, ir tai iš tikrųjų yra pakankamai gera. Jis sukūrė maždaug vieną sekundę garso per sekundę nuo išvados ir perteikia tonines emocijas, tačiau yra toks perdėtas, kad nesijaučia natūralu. Ir tai yra visos problemos raktas – modeliams trūksta tiek kontekstinio supratimo, kad sunku atskirti vieną emociją be papildomų užuominų ir padaryti ją pakankamai nuoseklų, kad žmonės iš tikrųjų patikėtų, kad tai yra natūralios sąveikos dalis

„Uncanny Valley“ efektas kelia ypatingą iššūkį, nes sintetinė kalba negali kompensuoti neutralaus robotinio balso paprasčiausiai priimdamas emocingesnį toną.

Ir yra daugiau techninių kliūčių. PG sistemos dažnai veikia blogai, kai tikrinamos garsiakalbiai, neįtraukti į jų mokymo duomenis-problema, vadinama mažu klasifikavimo tikslumu nepriklausomuose kalbėtojų eksperimentuose. Realiojo laiko emocinės kalbos apdorojimui reikalinga didelė skaičiavimo galia, ribojant dislokavimą vartotojų prietaisuose.

Duomenų kokybė ir šališkumas taip pat kelia dideles kliūtis. Mokant AI emocinei kalbai, reikia didelių, įvairių duomenų rinkinių, fiksuojančių emocijas demografiniuose demografiniuose, kalbose ir kontekstuose. Sistemos, apmokytos konkrečios grupės, gali būti nepakankamai su kitais, pavyzdžiui, AI, daugiausia mokoma pagal Kaukazo kalbos modelius, gali kovoti su kitomis demografiniais rodikliais.

Turbūt iš esmės kai kurie tyrėjai teigia, kad AI negali iš tikrųjų imituoti žmogaus emocijų dėl jos sąmonės trūkumo. Nors PG gali imituoti emocijas pagal modelius, jai trūksta gyvos patirties ir empatijos, kurią žmonės sukelia emocinei sąveikai.

Atspėk, kad žmogui yra sunkiau, nei atrodo. Atsiprašau, ChatGpt.

Paprastai protingas Informacinis biuletenis

Savaitės AI kelionė, kurią pasakojo generacinis AI modelis.